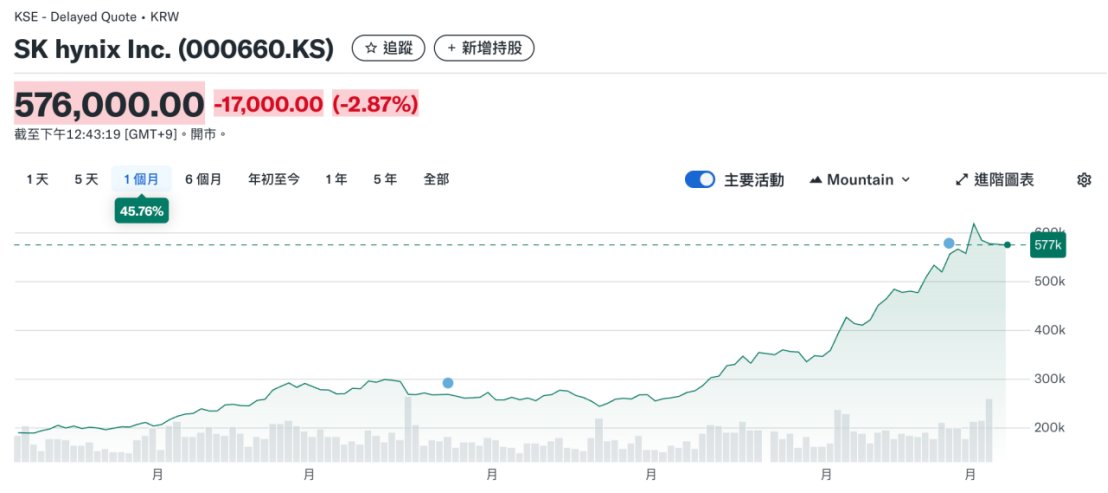

近期韩国股市可谓如火如荼,特别是其储存巨头正是如日中天。就在上月初,@OpenAI 宣布与三星电子和SK海力士两家韩储存龙头建立合作关系,向星际之门项目供应存储芯片,一举将AI超级硬件周期从算力争霸衍生到储存竞赛。

可以说AI周期彻底重塑了全球存储供需格局。高带宽内存HBM成为数据中心和AI服务器的新宠,大模型训练和推理对内存容量和速度的追求,让产业巨头纷纷将产能从传统消费级内存向高附加值方向倾斜。

数据显示,2025年HBM市场年增长率将接近70%,高端SSD和QLC NAND的增速也在30%以上。头部厂商如三星、SK海力士、美光均调高价格,模块厂商开始囤货应对缺货潮。与此同时,全球数据中心加速AI服务器投资,导致传统内存产品长期短缺,供需错配进一步加剧价格上涨。

结构性再分配导致DDR、LPDDR等产品供应被压缩,消费市场被动吃紧,产品价格几乎是一夜之间翻倍。尤其是在韩国企业主导上游环节的现实下,中国市场出现每天一个,部分产线甚至暂停报价。根据TrendForce和Commercial Times两大媒体的报道,部分DRAM和NAND产品报价仅当天有效,供需紧张预计将延续至2026年上半年。

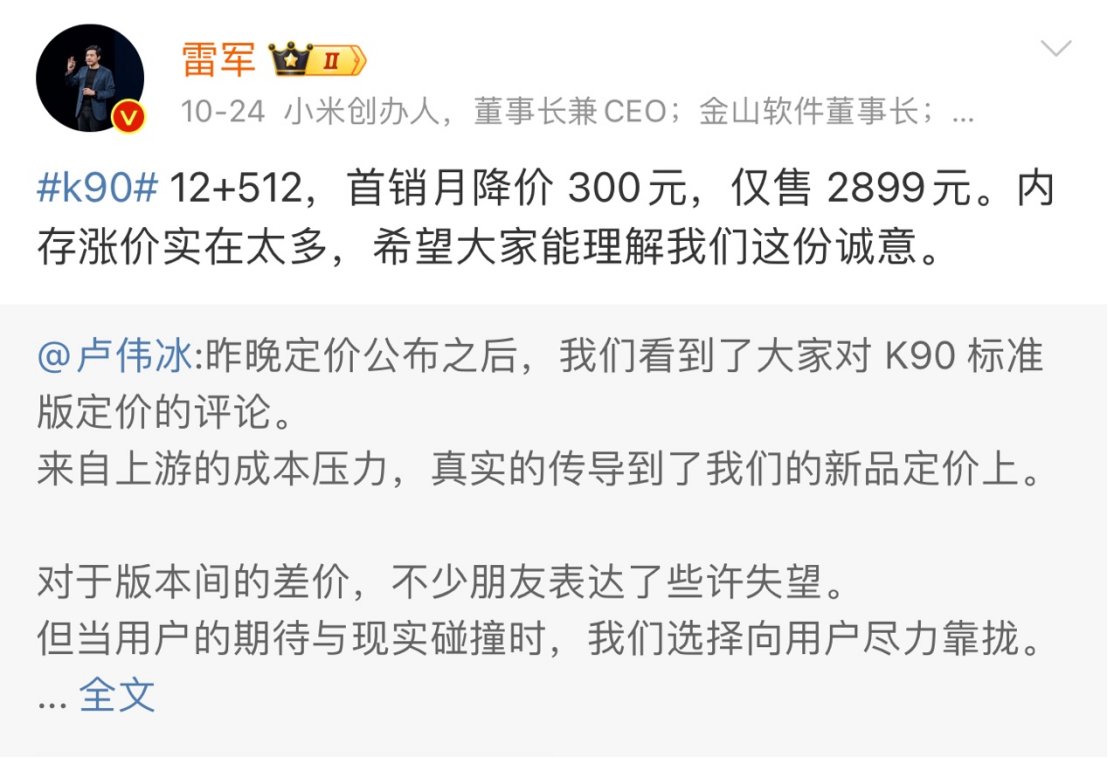

这对产业结构的影响是深远的。以小米集团为例,10月下旬红米 K90 系列发布时,上演了一出定价反转的戏码:起初公布的标准版 12GB+256GB 价格为 2599 元,而 12GB+512GB 版本却一下定在 3199 元,仅仅多出 256GB 存储,价差就高达 600 元,引发外界强烈质疑与热议。

发布会次日上午雷军在微博上表示内存涨价实在太多。细纠这款产品,红米 K90 系列在内存与闪存用料上主要采用行业头部厂商方案,例如K90 Pro Max 就配备了 SK 海力士 LPDDR5X 9600 规格的内存。

而在此之前我们提到,由于AI的超级硬件周期,储存厂商更专注于生产高附加值的储存芯片HBM,将本应生产用于移动端LPDDR系列的产能进行了高度压缩,使得供需完全失衡。小米集团内部马志宇甚至警告说:明年最新的成本预估有点惊悚

而所谓的HBM是一种专门为高性能计算、AI训练和推理、大型数据中心等场景打造的新一代存储技术。它的本质是利用3D堆叠技术,把多个DRAM芯片层以垂直方式叠加在一起,并通过芯片内部的贯穿硅通孔实现高速并行数据传输。

这种架构使HBM可以在极小的物理空间内实现超高容量和极宽的数据总线,通常达到1024位甚至更高,带宽比主流DDR5高出10至30倍。

回望2025年,AI服务器的HBM消耗年增率高达130%,未来还会以每年70%以上的增速扩大。HBM已成为各类AI服务器、高性能计算、超级计算机、图形加速卡的核心标配,是推动存储芯片价格上涨的最大主因之一。

AI产业所带动的储存需求导致传统储存芯片一芯难求,充分且饱和的竞争形成了红海市场。而实际上去中心化储存这一片蓝海却有待AI厂商慧眼识珠。

为什么这么说?从整机厂的视角来看内存是闪存是一起打包算钱的,例如之前提到的无论是12GB+256GB还是12GB+512GB都是一套组合定价,而不是两个独立商品。

这样的联动行情意味着扎堆生产HBM所带来的影响是双重的:即RAM与ROM的双螺旋飙升。

那么去中心化储存能否在RAM上有文章可言呢?

首先说RAM,LPDDR5是 Walrus @WalrusProtocol 这种去中心化存储的读写速度的几千到上万倍。官方论文实测里,与多个节点交互的情况下,单个客户端写一个大 blob 的写入吞吐大约在 ~18 MB/s 左右就到瓶颈了,但是主流 LPDDR5 速率可到 6400 Mb/s 每个引脚。

RAM是废了,那有没有什么其他说法呢?

答案是肯定的。以Walrus为例,本质上是带强安全、强冗余、可上链结算的下一代 Dropbox + S3 + CDN

怎么来理解呢?

Walrus 的第一大优势在于它首先具备去中心化和抗审查特性,通过数据切片与纠删码将数据分布到大量节点上,任何单个节点宕机或作恶都不会导致数据丢失,这就天然成为了去中心化的Dropbox服务。

同时其存储空间与 blob 在链上都是对象形态,可被智能合约直接操作,具备很强的可编程性,方便构建 AI 数据、RWA 以及去中心化前端等各类应用,这就具备了S3的雏形。

而Pipe Network 会作为 Walrus 的 content-delivery layer,用自己28万多个 PoP 节点帮 Walrus 做数据在边缘的加速分发,这也就是CDN。

这样的Dropbox + S3 + CDN组合具有得天独厚的优势。

在传统云上,S3 只管帮你把文件存好,至于谁在用、怎么用、用了多少,全都要你自己搭一整套后台,包括身份认证、权限校验、计费对账、分账逻辑,再配数据库去记录哪个模型、在哪个时间段、被哪个用户调用了多少次,运维和风控都压在自己团队身上。

Walrus 的思路是把这些都丢给Sui来做:存储是否存在由存储证明担保,文件是谁的、怎么收费写在对象元数据里,实际扣费和分账交给链上支付结算。

对那些需要社区共治、多方分成的开源模型或数据项目来说,这相当于从零到一地多出了一层公共账本,这也是Walrus强调为 AI 时代启用数据市场的根本原因。

假设你是一家做开源大模型的团队,训练出一个 70B 模型,不同数据配方下有十几个版本的 checkpoint。你可能希望:个人开发者可以免费拿来推理体验,但企业客户要按请求量付费。

同时,如果有人基于你的模型做二次微调并赚钱,你希望能自动拿到一定比例的分成,而不是靠线下合同和自觉。

那么在 Walrus 与 Sui 的运行逻辑里,每个 checkpoint 都是一个 Walrus blob,并在链上对应一个 ModelVersion 对象。你写的合约可以检查调用方是否持有企业 license,按请求权重的次数或流量自动计费,并按照约定比例把收入分给基础模型团队、数据集提供方和微调方。

这样一来,AI模型调用本身变成了链上的经济事件,而不是藏在某个中心化 API 日志里的黑箱。

再看AI数据集这一侧:数据提供方把 TB 级数据集存进 Walrus,得到一个 blob 和对应的 Dataset 对象;每次训练任务启动前,在链上声明本次使用的具体数据版本,并写入一个 TrainingRun 对象,记录模型版本、超参、数据集指针和最终结果。

以后任何第三方都可以据此审计这个模型究竟依赖了哪些数据、授权是否合规,一旦遇到监管或舆论质疑,也能用链上记录加存储证明给出相对硬的证据,这会慢慢演化成严肃 AI 厂商在Walrus上搭建的合规和品牌信誉上的长期优势。

因此,聪明的AI厂商已经开始考虑Walrus,Walrus正在等候属于它的沸点。